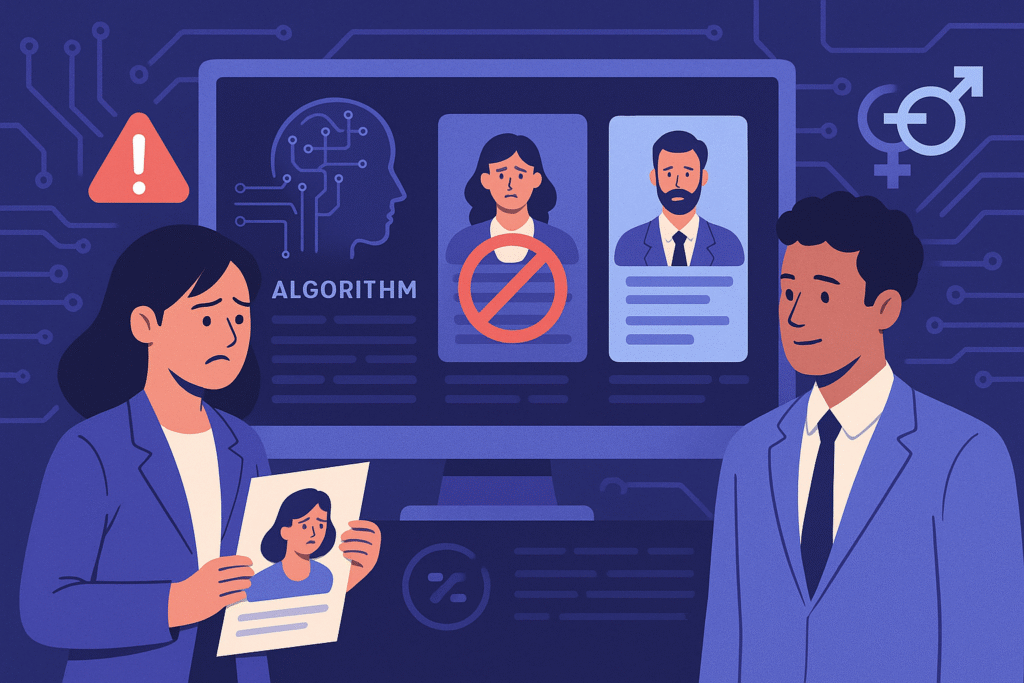

El Defensor de Derechos de Francia (Défenseur des droits) emitió una sentencia histórica en 2022, imponiendo una multa de €300.000 a una empresa por utilizar algoritmos de empleo que discriminaban a mujeres.

⚡ Resumen en 1 minuto

- 🔹 El ente de igualdad de Francia multó con €300.000 a una empresa por un algoritmo de empleo sexista.

- 🔹 La IA favorecía perfiles masculinos en roles técnicos y reducía visibilidad para mujeres.

- 🔹 El fallo exige auditorías de datos y lenguaje neutral en sistemas de reclutamiento automatizados.

- 🔹 Se reveló que el 70% de los datos de entrenamiento estaban centrados en hombres.

- 🔹 Este precedente podría influir en la regulación de IA laboral en toda la Unión Europea.

La IA detrás de sus anuncios priorizaba candidatos masculinos y ocultaba vacantes a perfiles femeninos en sectores técnicos —una práctica que el organismo consideró una violación directa del principio de igualdad profesional.

Este caso ha reavivado el debate sobre el papel de la inteligencia artificial en los procesos de reclutamiento y el riesgo de perpetuar sesgos históricos a gran escala si los modelos no son auditados adecuadamente.

🧩 ¿Cómo operaba el algoritmo?

La investigación reveló que el sistema publicitario utilizaba segmentación automática basada en patrones de comportamiento previos, lo que llevó a excluir a mujeres de ciertos anuncios de ingeniería y TI.

El sesgo se originó en el entrenamiento del modelo:

Te puede interesar:

- 🔸 70% de los datos de entrenamiento provenían de perfiles masculinos.

- 🔸 Las palabras clave más relevantes estaban asociadas a términos como “agresivo” o “competitivo”.

- 🔸 Los anuncios mostrados a mujeres eran principalmente de sectores asistenciales o administrativos.

En pruebas controladas, los investigadores comprobaron que un mismo currículo con nombre masculino tenía el doble de posibilidades de recibir una oferta que uno femenino equivalente.

Te puede interesar: ROG Xbox Ally X: Innovación con IA y el Debate por su Precio en 2025

🧠 Cómo evitar sesgos en algoritmos de reclutamiento

Reducir el sesgo en IA de empleo no requiere magia, sino metodología, diversidad y revisión continua.

Aquí las tres estrategias más efectivas:

| Enfoque | Método | Caso de uso | Opción híbrida |

|---|---|---|---|

| Auditoría de datos | Escanear los conjuntos de datos para detectar desbalances de género antes del entrenamiento. | Ideal para startups que entrenan sus primeros modelos de reclutamiento. | Combinar con revisión humana periódica. |

| Ajuste de terminología | Sustituir palabras sesgadas por lenguaje neutro (ej. “colaborativo” en lugar de “agresivo”). | Perfecto para marketing y RRHH. | Complementar con pruebas A/B de engagement. |

| Entrenamiento inclusivo | Incluir 50% de perfiles no tradicionales o de género diverso en cada actualización del modelo. | Escalable para empresas grandes con reclutamiento automatizado. | Integrar con auditorías trimestrales. |

📊 Estos métodos pueden aumentar la diversidad de postulantes entre un 15% y 25% y reducir disparidades de género en las vistas de anuncios en menos de seis meses.

👩💼 Impacto en las mujeres y el mercado laboral

Los resultados del fallo francés ponen de relieve cómo la IA mal configurada puede reforzar desigualdades estructurales.

Estudios recientes confirman que las mujeres reciben hasta 25% menos oportunidades en plataformas de empleo cuando los algoritmos utilizan datos históricos sin balancear.

Un ejemplo positivo: una empresa tecnológica francesa reemplazó el término “rockstar developer” por “ingeniero de software calificado”.

¿El resultado? 📈 Un aumento del 20% en solicitudes femeninas y una mejora en la calidad general del talento reclutado.

Te puede interesar: OpenAI y LinkedIn lanzarán plataforma de empleo con IA en 2026: revolución en la búsqueda de trabajo

🧰 Herramientas recomendadas para detección de sesgos

Si gestionas equipos de reclutamiento o desarrollas sistemas de IA, estas herramientas te ayudarán a detectar sesgos antes de que escalen:

- AIF360 (IBM) → mide métricas de equidad y sesgo.

- Textio → analiza lenguaje de género en descripciones de puestos.

- OpenRefine + SMOTE → limpia y equilibra datasets con técnicas de sobremuestreo.

- Faker (Python) → anonimiza datos sensibles en procesos de entrenamiento.

Implementarlas puede reducir sesgos entre 40% y 60% durante las primeras rondas de ajuste del modelo.

🌍 Implicaciones globales y lo que viene

El fallo de Francia podría ser el primer paso hacia una regulación internacional de la IA aplicada al empleo.

La Unión Europea ya avanza con su AI Act, que clasifica los sistemas de reclutamiento automatizados como de “riesgo alto”, lo que implicará auditorías obligatorias, explicabilidad y trazabilidad de decisiones.

Te puede interesar:

Las empresas que no se preparen podrían enfrentar sanciones millonarias y pérdida de reputación, además de la erosión de la confianza de los candidatos.

Los expertos recomiendan:

- 🧾 Auditar trimestralmente los algoritmos de RRHH.

- 🧍♀️ Formar equipos multidisciplinarios con perspectiva de género.

- 🧩 Incluir datos de múltiples fuentes y regiones.

- ⚙️ Monitorear decisiones automatizadas con métricas de equidad.

🔗 Fuentes consultadas

Le Monde – Défenseur des droits: algorithmes discriminatoires